写在前面,Deepseek使用一段时间了,感觉非常不错从生活到工作,多了一个有趣知识面广又有深度的助理,原来Ai也应用在工作生活中,但是没有这次多。值得大家去研究使用。原来有问题问度娘,现在有问题问Deepseek。

Deepseek网上有很多的教搭建,自己搭建完了,也搭建了本地知识库,把方法整理出来了,希望大家喜欢。

还有文中所有的链接都是官方网站的链接,可以放心的打开,不放心的就上网搜索吧。

Ollama +AnythingLLM (部署本地知识库)

Ollama +Cherry Studio (部署本地知识库)

Ollama +Page Assist (搭建本地知识库,这个可以联网使用Deepseek)

还有一个Ollma+ChatBoX 这个也是可以的,大家可以自行去下载使用,这几个软件我都下载来试用来,AnythingLLM可以直接调用Deepseek的API ,DeepSeek 开放平台 API 申请地址。

AnythingLLM和Page Assit 可以调用本地大模型,也可以调用局域网或是网络里自己搭建的大模型,后面我会一一说明怎么搭建。

当然也有教满血版使用的,有用硅基流动的、国家超算中心也有发布满血版,还有刚才说的直接使用Deepseek API,或是直接使用网页版。

一、deepseek大模型本地运行环境

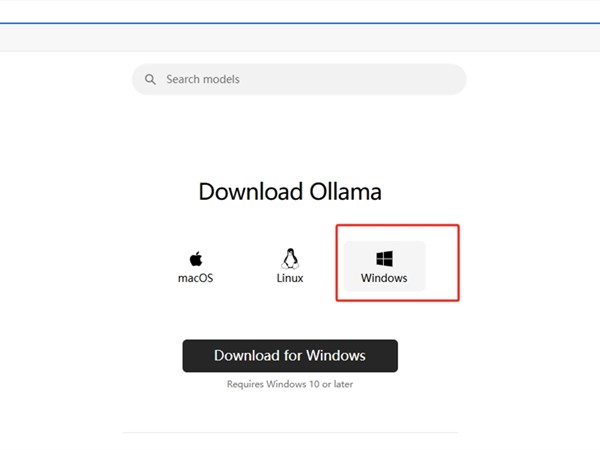

先下载Ollama ,Download Ollama on Windows 这是Windows 下载的链接,Download Ollama on Linux和Download Ollama on macOS ,Linux和Macos 直接点击链接去下载就可以。

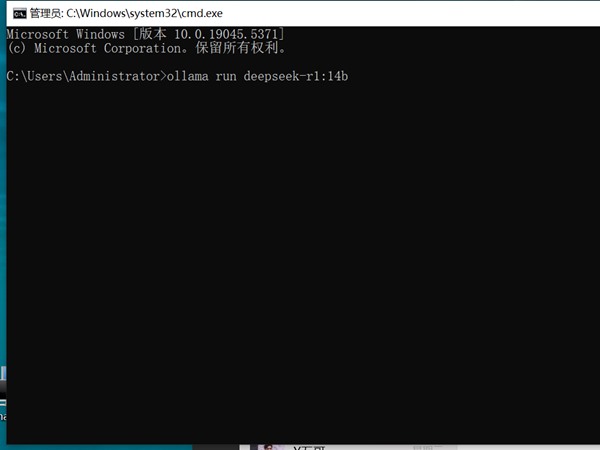

二、Ollma安转完成,打开运行(Win+R)输入cmd 回车。

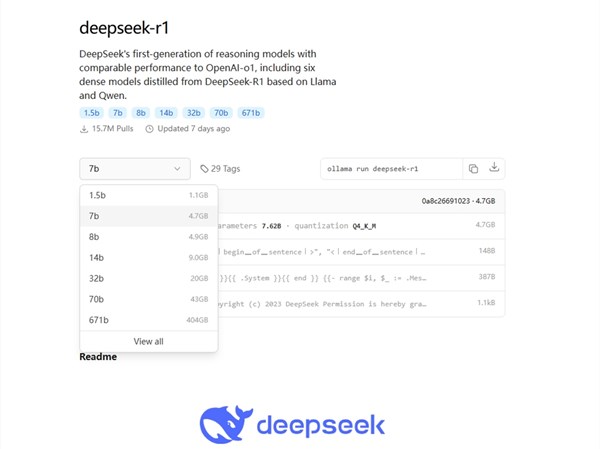

打开Ollma Models ,找到deepseek-r1 大模型,

选择要运行的模型来下载,ollama run deepseek-r1:1.5b,ollama run deepseek-r1:7b,ollama run deepseek-r1:8b,ollama run deepseek-r1:14b,ollama run deepseek-r1:32b,ollama run deepseek-r1:70b,ollama run deepseek-r1:671b。

复制模型到刚才打开的CMD里面粘贴回车就可以下载了。

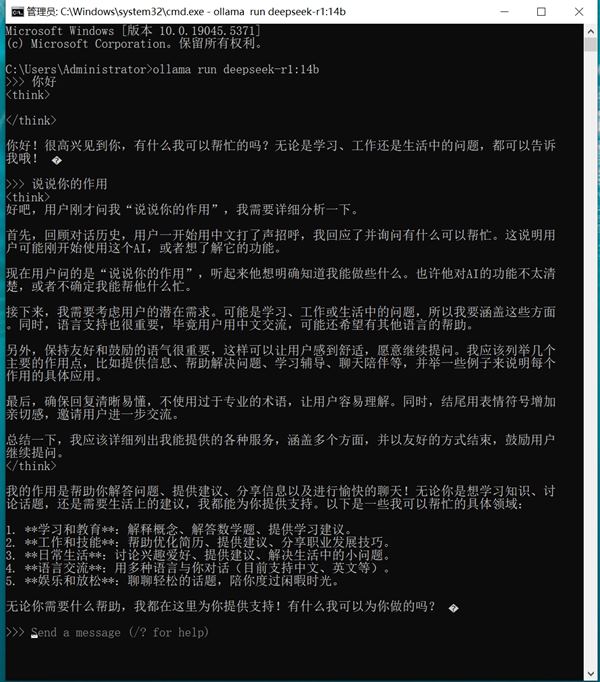

下载完成就是可以使用了。如果不知道自己的电脑配置是否跑的顺畅,就都下载一下,下载完运行,看你电脑配置是否能运行的起来。

我的电脑是英伟达4060 8G显存所以想就运行了14B,可以自己多多尝试,弄错了没事,卸载的重新安装,对不?

没有回复内容